Xataka – En 1978 Christopher Reeve fue elegido para interpretar a ‘Superman’. Se puso tan mazado que literalmente no cabía en el traje

A mediados de los setenta, Superman no era solo un personaje: era la gallina de los huevos de oro de DC y una apuesta que podía consagrar o hundir el primer gran blockbuster moderno de superhéroes. Los productores Alexander e Ilya Salkind querían una película “seria” y grandiosa, lejos del tono camp del Batman de los sesenta, pero también sabían que cualquier tropiezo sería un bochorno histórico.

Demasiado grande para fallar. En ese escenario, DC, recelosa, impuso condiciones de lo más estrictas y vigiló el proyecto como si fuera una operación quirúrgica, porque el problema de fondo no era hacer una película: era hacerla con un tipo en mallas y capa roja y lograr que el público lo mirara con respeto, no como un meme.

Dos años de casting. Así, la búsqueda del Superman perfecto se convirtió en el gran cuello de botella: comenzó en 1975 y se alargó hasta febrero de 1977, con centenares de pruebas y una sensación creciente de desesperación. Hubo, como suele pasar en toda gran producción, una “wish list” de estrellas que parecía más un cartel de festival que una audición: Robert Redford, Paul Newman, Warren Beatty, Clint Eastwood, Steve McQueen, Burt Reynolds, Charles Bronson, James Caan, o incluso Nick Nolte.

De hecho, hubo muchos más, además de propuestas que hoy suenan delirantes por pura lógica de marketing, como pensar en Muhammad Ali o incluso en gente ajena a la interpretación. Ocurre que cada opción fallaba por algo (si no era el coste, era la edad, la imagen, el acento o el encaje en general) y el mensaje era claro: sin Superman, no había película.

El giro definitivo. En medio de ese caos, Christopher Reeve llegó desde el teatro neoyorquino como una respuesta que no encajaba con el cliché del “nombre grande” que buscaban los productores, pero sí con la esencia del personaje. La directora de casting fue empujando su candidatura contra la inercia del equipo, hasta que por fin le dieron una oportunidad real.

Cuando Richard Donner, el director de la peli, lo vio, el juicio fue tan claro como incómodo: Reeve tenía la altura, la cara y el aura para ser Superman… pero también era demasiado joven y demasiado delgado (“un palo”, fueron las palabras del director) para rellenar un traje que exigía fuerza visible, no solo presencia. Aun así, en aquella prueba (entre nervios, calor de focos y un aspecto todavía desgarbado) quedó patente algo que nadie podía copiar: el potencial de hacer creíble a Clark Kent y a Superman en la misma persona.

El actor antes de optar a su papel en Superman

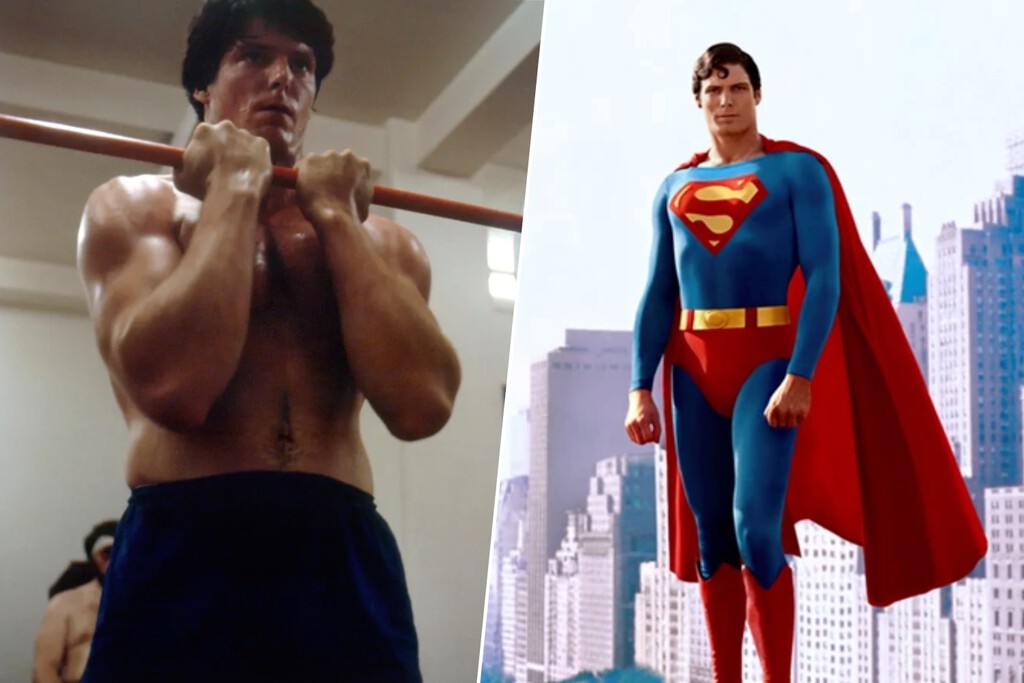

Dejar de ser un “palo”. Reeve consiguió el papel con una exigencia tácita que en realidad era un ultimátum: tenía que convertirse físicamente en Superman, y además hacerlo rápido. Los productores llegaron a sugerirle usar músculos falsos debajo del traje para “engañar” a cámara, una solución típica del cine de la época, pero él se negó, porque entendió que la credibilidad no se construía con relleno, sino con transformación.

La película necesitaba que el cuerpo dijera “superhéroe” antes incluso de que el personaje hablara, y Reeve asumió que el trabajo no era solo actuar bien, sino parecer imposible sin caer en el exceso.

Darth Vader como entrenador. Aquí entra la anécdota que parece inventada por un departamento de publicidad: el hombre que iba dentro del traje de Darth Vader, David Prowse, también culturista e instructor, fue quien se encargó de esculpir a Superman. Donner lo llamó como quien activa un plan de emergencia: “tenemos un Superman” y hay que construirlo a contrarreloj.

Prowse entrenó a Reeve durante semanas con una rutina enfocada a ganar masa y fuerza funcional, lo bastante sólida como para aguantar arneses de vuelo, jornadas extenuantes y el peso simbólico del personaje. Y en el proceso nació un relato perfecto para vender la película: el villano físico más intimidante del momento moldeando al héroe definitivo de la década.

La “obsesiva” transformación. El método fue tan sencillo como brutal: comer muchísimo, entrenar a conciencia y no permitirse perder peso ni un solo día. Reeve se sometió a una dieta hiperproteica, con cuatro comidas diarias, batidos y vitaminas, y con una disciplina casi paranoica: saltarse una comida significaba retroceder, y retroceder era un desastre.

La idea que repetía era muy clara: el trabajo interior del actor no sirve si el exterior no sostiene la fantasía, porque Superman no puede “parecer” débil, aunque sea vulnerable por dentro. Y lo más interesante es que esa fuerza física le cambió también la psicología del papel: cuanto más fuerte se volvía, más natural le salía la autoridad tranquila del personaje.

Demasiado «cachas». El resultado fue tan exageradamente efectivo que se convirtió en un problema de continuidad: Reeve siguió ganando músculo durante el rodaje y llegó un punto en el que no era el mismo cuerpo de las primeras escenas. La producción tuvo que rehacer tomas ya filmadas porque el Superman de un día no cuadraba con el Superman de semanas después, y el traje, pensado para un “antes”, empezó a comportarse como una carcasa que se quedaba pequeña.

El giro irónico es que al principio querían ponerle músculos falsos bajo el uniforme y, tras la transformación, ocurrió lo contrario: pudieron retirar los añadidos del traje porque ya no hacían falta, y la película se quedó con lo que siempre había necesitado desde el principio, un Superman con músculo real, sin trampa ni cartón.

El mito que quedó. Con el tiempo, el físico de Reeve se ha comparado con los estándares hipertrofiados de los superhéroes actuales, pero en su momento fue todo un acontecimiento: su cambio de “actor alto y flaco” a icono musculado formó parte del propio relato de Superman antes incluso del estreno.

Lo importante no fue competir con montañas de bíceps modernas, sino construir una ilusión exacta: que ese tipo podía ser el más poderoso del planeta y, aun así, el más humano cuando miraba a Lois Lane. Al final, su Superman no solo funcionó por el carisma o la interpretación de Reeve (que también), sino porque el cuerpo dejó de ser un obstáculo y pasó a ser una prueba: si el traje casi no podía contenerlo, el público tampoco tenía por qué dudarlo.

Imagen | Warner

–

La noticia

En 1978 Christopher Reeve fue elegido para interpretar a ‘Superman’. Se puso tan mazado que literalmente no cabía en el traje

fue publicada originalmente en

Xataka

por

Miguel Jorge

.